Lanzamiento de o3‑Pro de OpenAI, lleva el razonamiento al máximo.

OpenAI ha presentado o3‑Pro ahora en junio de 2025, como la versión más avanzada de su modelo de razonamiento profundo en la serie o3. Este modelo está disponible para usuarios de ChatGPT Pro, Team, y próximamente para cuentas Enterprise y Edu vía API. Se diseñó para "pensar más tiempo y ofrecer respuestas más fiables", apuntando a casos donde la precisión importa más que la velocidad.

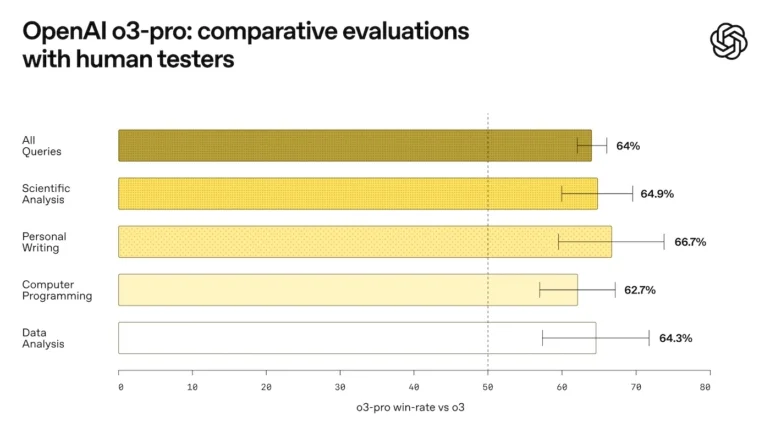

La mayor fortaleza de o3‑Pro radica en su capacidad de razonamiento paso a paso, mostrando mejoras significativas frente a o3 y o1‑Pro en ámbitos como ciencias, programación, análisis de datos y redacción. En pruebas internas de confiabilidad 4/4, superó a sus versiones anteriores, destacando especialmente en claridad e interpretación de instrucciones complejas.

Otra novedad es su integración con herramientas: o3‑Pro puede explorar la web en tiempo real, analizar archivos (incluyendo PDFs e imágenes), ejecutar códigos en Python y aplicar visión computacional. Esto lo convierte en un modelo altamente versátil, más allá de la generación de texto, ideal para agentes de IA complejos—y da incluso para hilar comentarios: “es como tener un investigador, programador y detective en una sola API”.

Eso sí, este power‑house lleva su precio. El coste es de 20 USD por millón de entrada y 80 USD por millón de salida, un nivel diez veces superior al del o3 base. Además, esta mayor capacidad conversacional conlleva tiempo: cada respuesta puede tardar minutos, por lo que se recomienda su uso solo cuando se prioriza la fiabilidad sobre la velocidad.

La comunidad técnica ha reaccionado con entusiasmo: según evaluaciones, una mayoría prefirió o3‑Pro frente a o3 en preguntas científicas, de codificación y de análisis. Sin embargo, algunos usuarios advierten: “es tan inteligente que podría pasarse quince minutos resolviendo un chiste malo”—una forma divertida de ilustrar su capacidad para procesar información; se asemeja a como reaccionaría un "cerebrito" humano.

Quieres mas info? Mirate el siguiente video:

OpenAI o3, gran bajada en los precios, pero potencia intacta.

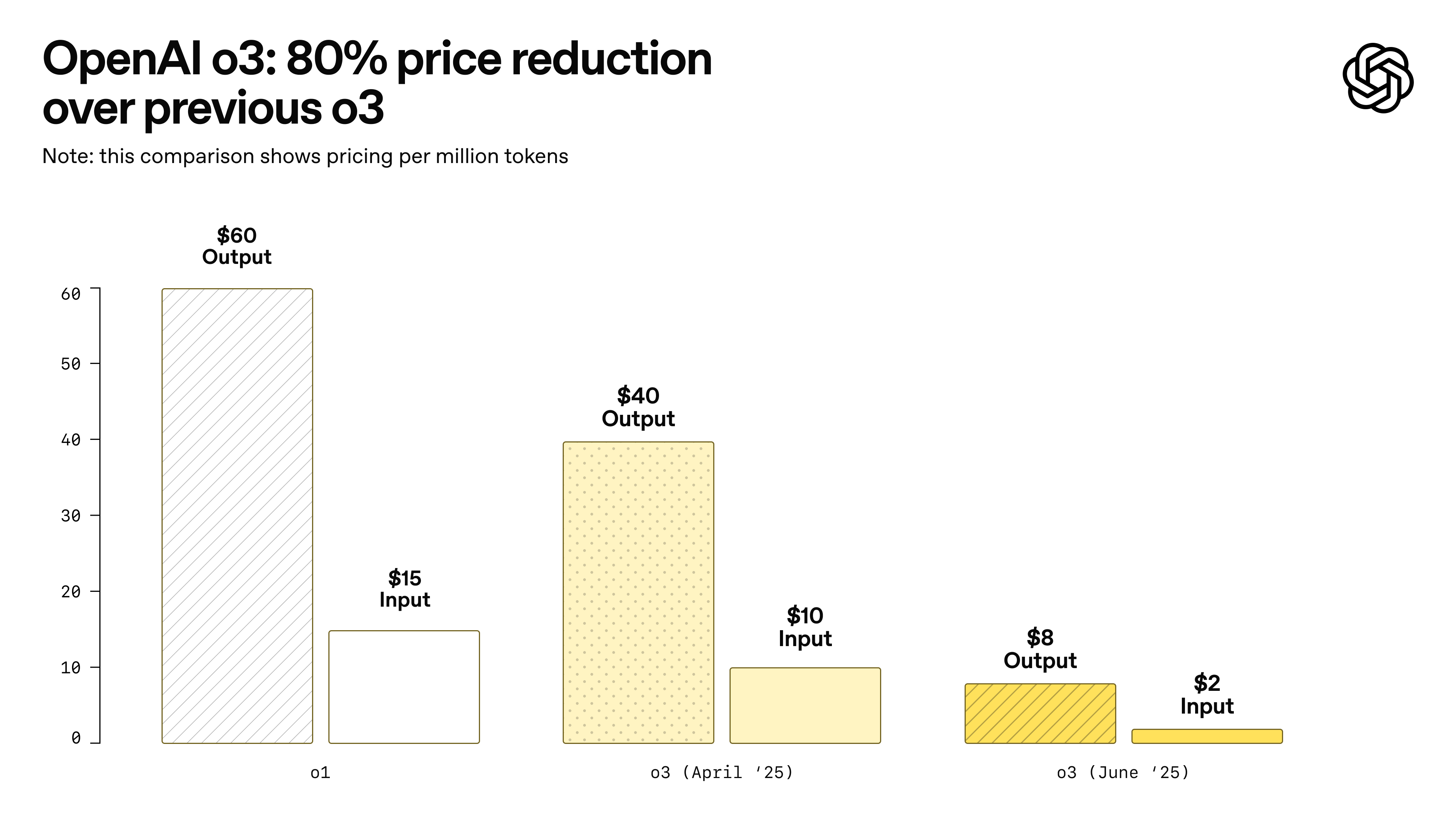

Y claro, a consecuencia del lanzamiento comentado de o3-PRO, OpenAI ha anunciado una reducción del 80 % en el precio del modelo o3 directamente en su API. Antes costaba 10 $ por millón de tokens de entrada y 40 $ por millón de salida; ahora esos valores son de 2 $ y 8 $ respectivamente, con un descuento adicional de 0,50 $ por tokens cacheados. Este movimiento convierte a o3 en una opción competitiva frente a Gemini 2.5 Pro y Claude Opus 4, abriendo la puerta a su adopción por desarrolladores y startups.

Técnicamente, esta bajada no sacrifica rendimiento. Manteniendo su arquitectura de ‘chain-of-thought’, o3 conserva su capacidad de razonamiento avanzado, pero ahora es más asequible para realizar procesamiento de grandes volúmenes de tokens. Curiosamente, algunos desarrolladores han bromeado que o3 ahora cuesta menos que ese café que compras cada mañana… ¡y te despierta igual!

La reducción de precio también trae consigo el lanzamiento de o3‑Pro, una versión potente orientada a tareas complejas. Disponible para usuarios Pro y Team, cuesta 20 $/millón de entrada y 80 $/salida, ofreciendo acceso a capacidades de búsqueda en web, análisis de archivos, ejecución de código y visión computacional.

En cuanto a uso real, la disminución de costes permite que o3 se convierta en una herramienta viable para muchas más aplicaciones: desde asistentes inteligentes hasta análisis de datos en tiempo real. El descuento en tokens cacheados también alienta a diseñar flujos de trabajo optimizados donde se reutilizan prompts frecuentes.

La comunidad técnica ha recibido la noticia con entusiasmo. Plataformas como Cursor ya descuentan o3 de sus planes al mismo nivel que GPT‑4o, y resellers como Windsurf también ajustan sus créditos hacia o3 Reasoning. Los foros y redes se llenan de “LFG!” (Let’s F-ing Go), traducido como: “¡vamos a construir sin arruinarnos!”.

En perspectiva, esta estrategia de precios coloca a OpenAI en una posición dominante en el mercado de IA, fomentando una adopción masiva y presionando a competidores a reaccionar. En un mercado en el que el coste de los tokens tiende a cero mientras la inteligencia crece, o3 se convierte en el modelo más accesible sin renunciar a la calidad.

Influencia de la IA en las decisiones de compra de los usuarios.

Un estudio reciente analiza cómo las interacciones con grandes modelos de lenguaje (LLMs) influyen directamente en las decisiones de compra de los usuarios tras recibir sugerencias de productos. El modelo examina conversaciones y detecta cuándo un usuario ha identificado un artículo o servicio a través de la IA. Los datos revelan que más del 35 % de los usuarios efectúan una compra después, lo que confirma la efectividad del marketing conversacional en tiempo real.

En términos técnicos, la investigación utiliza métricas como “Presence Score” para medir la visibilidad de productos dentro de las respuestas generadas por los LLMs. Cuanto más prominente y relevante aparece un producto en la respuesta, mayor es la probabilidad de que se concrete en una compra. El estudio también analiza cómo el posicionamiento semántico, y no solo textual, genera resultados más efectivos que los métodos tradicionales de SEO.

Otro hallazgo clave es el uso de preferred-item inference, donde el LLM infiere preferencias del usuario en base a sus interacciones previas. Al identificar patrones como “estoy organizando una fiesta” o “necesito regalo para mi pareja”, el sistema ofrece sugerencias contextuales de alta conversión. Esta funcionalidad semántica permite generar recomendaciones más naturales y personalizadas.

Desde el punto de vista del desarrollo, el estudio confirma que los LLMs que combinan análisis de contexto, historial de usuario y conocimiento de catálogo pueden construir perfiles activos que se actualizan dinámicamente. Herramientas como k__Ecommerce, que contemplan perfiles contextuales, maximizan esta capacidad. El modelo exhibe comprensión profunda de los productos de un site, y puede adaptar la conversación para guiar hacia la acción de compra.

Los LLMs conversacionales tienen un impacto directo en las decisiones de compra, gracias a su capacidad de inferir intenciones, posicionar productos y actualizar perfiles dinámicamente. Para desarrolladores y cadenas de ecommerce, integrar herramientas IA conversacional como k__eCommerce, no solo mejora la UX, sino que impulsa conversiones y redefine el recorrido del consumidor digital.

Si quieres conocer más de como k_eCommerce puede ayudarte a incrementar tus ventas, aqui tienes toda la info del producto.

Últimos avances en la Generación de Imagen y Vídeo con IA.

En las últimas semanas, Midjourney ha debutado con su esperado generador de vídeo V1, que transforma imágenes estáticas en clips de hasta 20 segundos. A partir de la versión v7, basta con generar o subir una imagen y presionar "Animate" para obtener un vídeo con movimiento de cámara y sujeto. La beta limitada ofrece opciones de movimiento bajo o alto, y añade hasta tres extensiones de 4 segundos cada una, abriendo una ventana a una narrativa visual fluida.

Mientras tanto, Runway ha consolidado su posición con Gen‑3 Alpha, ahora disponible para todos los usuarios. Este modelo mejora la coherencia de personajes, la suavidad de las transiciones y el movimiento de cámara. Disponible desde los 12 $/mes con límite mensual de generación, Gen‑3 Alpha acelera el desarrollo de producciones audiovisuales complejas sin requerir hardware local potente.

A diferencia de Runway, que ofrece excelente control pero sin audio automático, Veo 3 genera vídeo + sonido de forma integrada. Frente a Sora, la generación con lip-sync es total y nativa, algo que Runway y Pika solo ofrecen parcialmente.

Luma Labs también ha dado un salto significativo con su Dream Machine, que combina generación de vídeo con consistencia de estilo a través de "Photon" e incluso soporte de audio ambiental. Aunque la resolución inicial es moderada (~480p), su enfoque en transiciones cinemáticas y escenas musicales la convierte en una opción sólida para creadores modestos.

Por su parte, Krea ha mostrado avances sólidos en su beta de vídeo, integrando tecnologías como Hailuo, Kling y Luma dentro de flujos de trabajo unificados. Su interfaz en la nube permite generar vídeo en tiempo real a partir de imágenes o texto, lo que representa una competencia real para plataformas como Luma o Runway, especialmente en creatividad colaborativa.

En el campo académico, modelos como HunyuanVideo están cerrando la brecha entre soluciones cerradas y de código abierto. Con más de 13 mil millones de parámetros, ofrece calidad visual y coherencia de movimiento al nivel de Runway Gen-3, lo que abre la puerta a comunidades open‑source que buscan herramientas profesionales sin dependencia de licencias.

Estas actualizaciones evidencian una verdadera revolución multimodal: pasamos de imágenes estáticas a experiencias audiovisuales completas, accesibles tanto a profesionales como a entusiastas. Eso sí, aún falta perfeccionar aspectos como resolución, control de derechos de autor (en especial en Midjourney) y eficiencia de coste: la IA aún no es capaz de editar tu boda sin cobrar extra, pero al menos ya puede bailar el vals contigo.

Mirate este video de las nuevas capacidades de Midjourney Video... alucianante!

Eleven v3, potencia la expresiva de la síntesis de voz con IA.

En junio de 2025, ElevenLabs ha lanzado Eleven v3 (alpha), su modelo de texto a voz más avanzado hasta la fecha, centrado en la expresividad emocional y el control detallado de la entonación. A diferencia de versiones anteriores, v3 permite insertar audio tags como [whispers], [laughs] o [sighs] directamente en el texto, lo que habilita performances más auténticas y variadas. Esta innovación permite a creadores de audiolibros, videojuegos y cine elevar sus narrativas con matices que antes requerían grabaciones profesionales en estudio.

Supone un cambio radical en la generación de voz con la introducción del modo diálogo multi‑speaker, que permite encadenar conversaciones naturales con interrupciones y solapamientos vocales. Esto se consigue mediante el nuevo endpoint Text to Dialogue API, que gestiona múltiples turnos de conversación e infiere pausas, cambios de tono y fluidez discursiva. Ideal para podcasts, dramas de audio o sistemas conversacionales, v3 recupera la dinámica de una charla humana sin esfuerzo.

Otra mejora técnica significativa es la comprensión avanzada del texto por parte del modelo, lo que se traduce en entonación y estrés más precisos, especialmente en frases complejas o con emociones implícitas. El resultado es una voz más realista que puede transmitir sarcasmo, sorpresa o ritmo dramático con solo ajustar texto y etiquetas. Aunque requiere más prompt engineering, quienes lo prueban describen el resultado con frases como “una voz que ríe y susurra como si tuviera alma propia”.

En cuanto al alcance, Eleven v3 amplía el soporte a más de 70 idiomas, incluyendo hindi, bengalí o tamil, lo que lo hace ideal para proyectos globales. Sin embargo, debido a la mayor complejidad, su latencia es algo mayor, lo que lo hace menos adecuado para aplicaciones en tiempo real. ElevenLabs recomienda continuar utilizando sus modelos v2.5 Turbo o Flash para esos casos mientras trabajan en una versión optimizada para tiempo real.

Técnicamente, la versión alpha de v3 permite ajustar la estabilidad de la salida, con modos como Creative (más expresivo) o Robust (más consistente), lo que ayuda a balancear expresividad y fidelidad. Además, los “audio tags” ofrecen un control granular sobre la emoción, pausas y efectos sonoros — incluso [gunshot] o [clapping] — permitiendo resultados más cinematográficos, a menudo con un toque cómico: “Es como tener un actor dramático, un DJ y un director de orquesta en un solo script”.

Conoce mas en profundidad las nuevas posibildides de esta herramienta en el siguiente video: